在当今信息爆炸的时代,获取并分析网络上的数据成为许多人不可或缺的需求。为了满足这一需求whatsapp网页版,出现了许多网站内容抓取工具,它们以高效、自动化的特点,成为从互联网上提取信息的得力助手。在这篇文章中,我们将盘点六款专业的网站内容抓取工具,其中特别关注一款备受瞩目的工具——147免费采集软件。这款工具不仅支持通过关键词全网抓取文章,还能灵活指定任意网站进行抓取,实时监控抓取信息,实现全自动化操作。让我们深入了解这六款工具,以及147免费采集软件在其中的卓越表现。

1. 147免费采集软件:全网与指定网站采集的利器

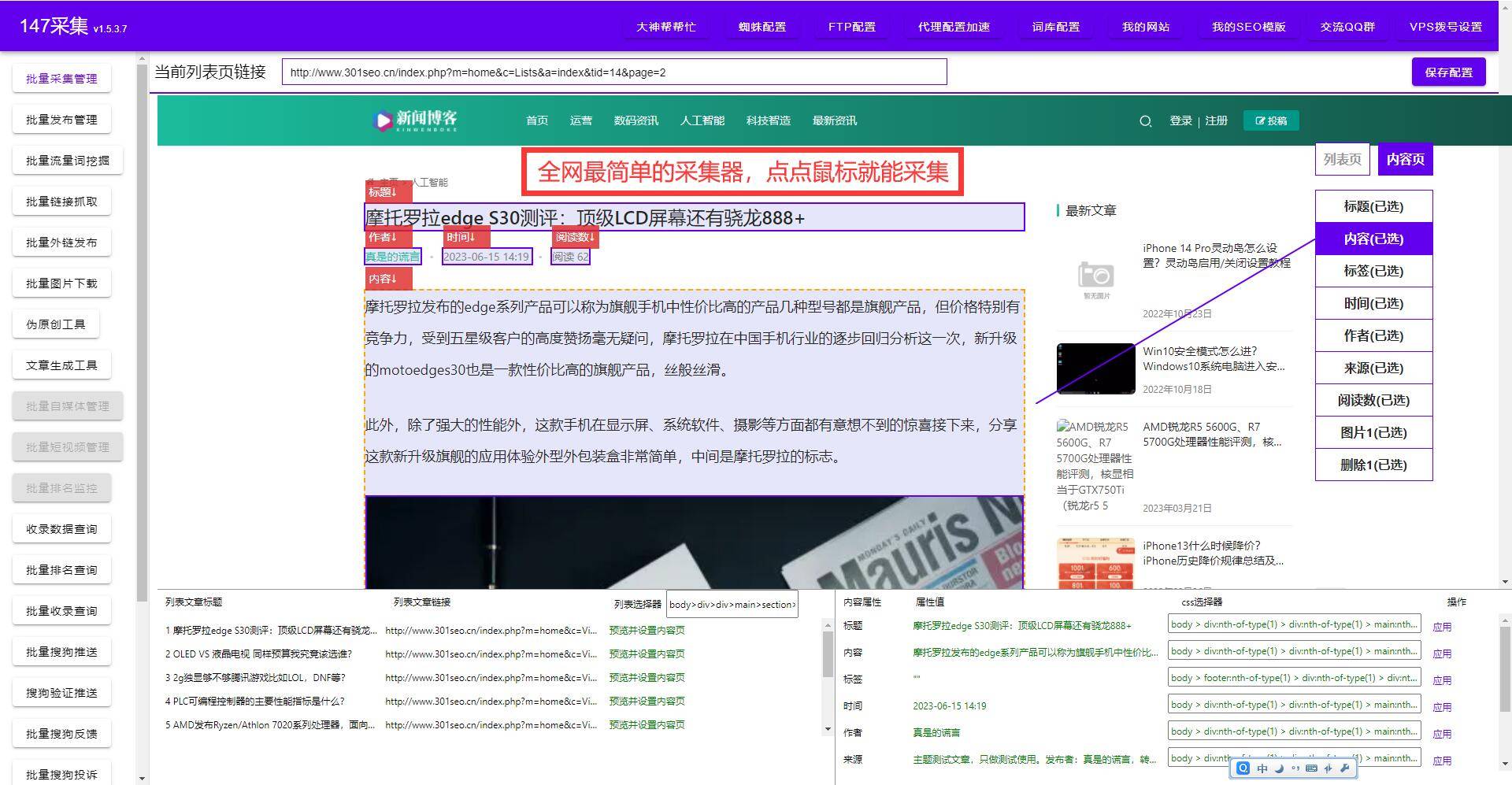

作为本文的亮点之一,147免费采集软件以其卓越的性能和全面的功能受到了广泛关注。用户只需输入关键词,即可实现全网抓取文章的操作。同时,其支持指定任意网站进行抓取的功能,使得用户在针对性的数据获取上更加得心应手。这款软件不仅具备高效的抓取能力,而且实现了监控实时抓取网站信息,用户只需设置好抓取规则后,即可放心全自动抓取,省去了繁琐的手动操作。

2. BeautifulSoup:Python中的网页解析库

BeautifulSoup是一个Python库,主要用于从HTML和XML文件中提取数据。虽然它本身并非专门的网络爬虫框架,但在网页内容的解析和提取方面表现出色。BeautifulSoup能够帮助开发者轻松地遍历HTML文档,查找、过滤出需要的信息。虽然需要结合其他库和模块来完成完整的网络爬取任务,但BeautifulSoup的简洁易用使其在小型项目或特定需求下成为独具价值的工具。

3. Scrapy:高级的Python网络爬虫框架

Scrapy是一个强大而灵活的Python开源网络爬虫框架,适用于大规模的数据提取任务。相较于BeautifulSoup,Scrapy需要用户具备一定的编程经验,因为它采用基于规则的方式来定义爬取流程。Scrapy支持异步处理和分布式爬取,为处理大规模数据提供了有效的解决方案。其高度的定制性和扩展性使得它成为开发者和数据科学家的首选之一。

4. Selenium:适用于动态网页的自动化测试工具

Selenium最初是一个自动化测试工具,但由于其强大的浏览器自动化功能,被广泛应用于网页内容抓取。与静态网页不同,动态网页的内容是通过JavaScript等技术动态生成的,传统的爬虫工具难以直接处理。Selenium通过模拟浏览器的行为,可以处理动态加载的内容,从而实现对动态网页的抓取。它的可视化界面和广泛的浏览器支持使得它成为处理复杂抓取任务的理想选择。

5. Apache Nutch:开源的网络爬虫框架

Apache Nutch是一个开源的、高度可配置的网络爬虫框架,由Apache软件基金会维护。它使用Java编写whatsapp网页版,具有高度的可扩展性和灵活性,可以满足各种不同规模和需求的爬取任务。Nutch支持针对性的深度爬取,能够通过配置实现对特定领域或主题的深入抓取。作为一款成熟的爬虫框架,Nutch在处理大规模数据时表现出色,被广泛应用于搜索引擎和数据挖掘领域。

6. ParseHub:可视化的网页数据抓取工具

ParseHub是一款强大的、可视化的网页数据抓取工具,为用户提供了直观友好的界面。其独特的“点选”功能允许用户通过简单的点击来选择需要抓取的数据,无需编写代码。除了支持静态页面,ParseHub还能轻松处理动态页面的内容。用户可以根据需求设置抓取规则和数据结构whatsapp网页版,并将数据导出为Excel、JSON等格式,方便后续的处理和分析。

通过对这六款网站内容抓取工具的盘点,我们可以看到它们各自的特点和适用场景。在选择工具时,需根据项目需求、个人技能水平以及数据规模等因素进行权衡。其中,147免费采集软件作为一款全网与指定网站采集的利器,具备全自动抓取和实时监控等强大功能,为用户提供了一种高效而便捷的抓取方案。